(图文 | 信息 编辑 | 辛西 审核 | 何新卫)近日,家庭教师av 2024级研究生王之川(导师:何新卫)撰写的1篇名为“Describe, Adapt and Combine: Empowering CLIP Encoders for Open-set 3D Object Retrieval”的文章被ICCV 2025录用。ICCV (International Conference on Computer Vision)是计算机视觉领域的三大顶级会议之一,也是中国计算机学会(CCF)推荐的人工智能方向A类会议,在学术界和工业界具有极高影响力。这是家庭教师av 独立完成并作为唯一通讯单位首次在ICCV上发表论文。

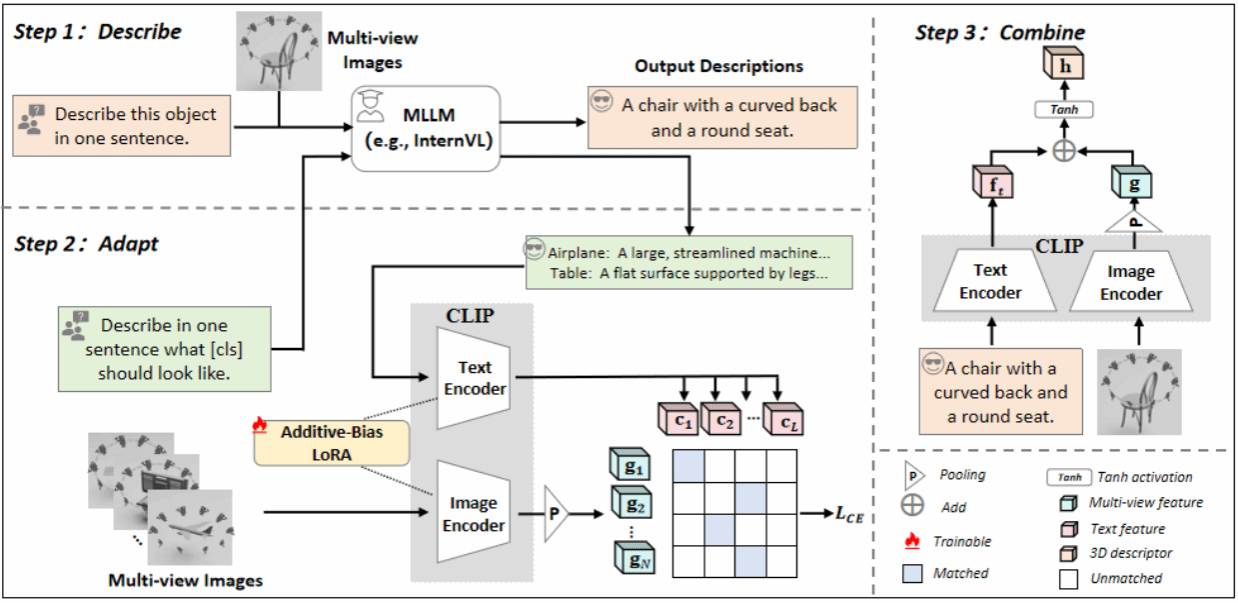

该研究聚焦于3D模型检索领域的前沿问题,创新性提出一种基于大规模预训练模型CLIP的轻量级适配框架——DAC,旨在解决开放场景下3D对象检索中的类别泛化难题。当前开放集3D对象检索方法通常依赖复杂的多模态输入(如点云、体素等)进行匹配与检索,而DAC则充分挖掘CLIP在自然图像上的强大表征能力,仅以多视角图像作为输入,并通过低秩适应(LoRA)策略进行高效微调。该过程仅需少量已知类别即可完成适配,显著提升了检索精度的同时也保证了方法的轻量化与实用性。同时为避免微调过程中对已知类别的过拟合,DAC引入了可学习且与输入无关的加性偏置(additive bias),从而在提升已知类检索性能的同时,有效保留模型对未知类别的泛化能力。此外,DAC进一步引入文本模态以辅助检索。具体而言,DAC借助多模态大模型为每个3D对象生成文本描述,这些描述提供了丰富的语义属性信息,显著增强了模型对未知类别的识别与特征匹配能力。

家庭教师av 2024级研究生王之川为该论文第一作者,人工智能系王玉龙、何新卫为论文通讯作者。该研究也得到深圳大学周漾副教授、香港大学博士后研究员刘哲、美国路易斯维尔大学助理教授俞睿、新加坡字节跳动人工智能实验室计算机视觉主管柏松,以及华中科技大学白翔教授的指导帮助。该工作获国家自然科学基金青年项目、湖北省自然科学青年基金项目和校自主创新基金支持。