(图文|江烨皓 编辑|信息 审核|王海燕)近日,我校家庭教师av 王海燕副教授课题组在Computers and Electronics in Agriculture杂志在线发表题为“Body Parts Segmentation and Phenotypic Traits Extraction of Pig Using an Improved Point Cloud Segmentation Network with Multi-LiDAR”的研究论文。该研究提出一种基于激光雷达和点云分割技术的猪体尺非接触式测量方法,成功重建了猪在真实场景下的三维立体模型,实现了猪在自由站立姿态下高精度体尺测量,为猪的表型测定和遗传评估提供了新方案。

猪的体尺是重要的表型评价指标,精准的体尺测量可为遗传评估提供参数,帮助筛选生长性能优良、体型符合目标的种猪,加速品种改良进程,是现代智慧育种和精细化养殖管理的核心基础。传统人工测量方法需将猪驱赶到半封闭式笼秤中保持固定姿态进行测量,不仅耗时费力,且狭小受限的空间环境会引发猪的应激反应,从而影响体尺测量的准确性。随着计算机视觉技术和三维重建技术的发展,通过重建猪的三维模型来精确定位测量点进行体尺计算,不仅能显著提高测量精度,还能提取新的体尺指标,大幅拓宽猪表型评价指标的范围。

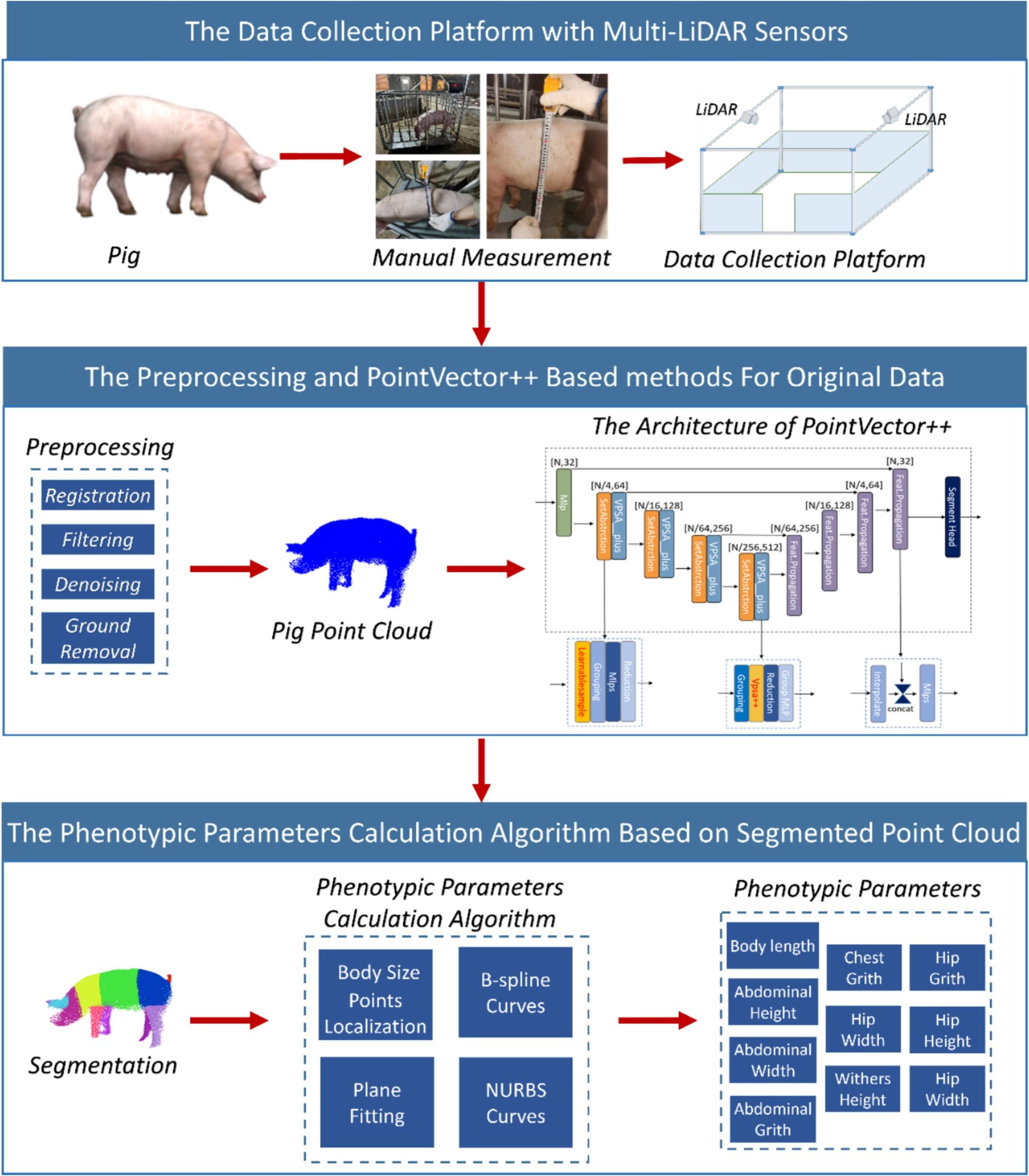

为实现非接触、智能化猪体尺指标测定,本研究使用激光雷达构建了猪自由站立姿态下非接触式点云数据采集平台,并结合深度学习点云分割、体尺测量点定位、曲线曲面拟合等技术,提出一种基于激光雷达和点云分割模型的猪体尺测量方法。首先,本研究构建的基于激光雷达的三维点云采集系统,该平台能完成高质量的猪点云数据的收集(如图1所示)。

图1 基于激光雷达和点云分割模型的猪体尺测量方法

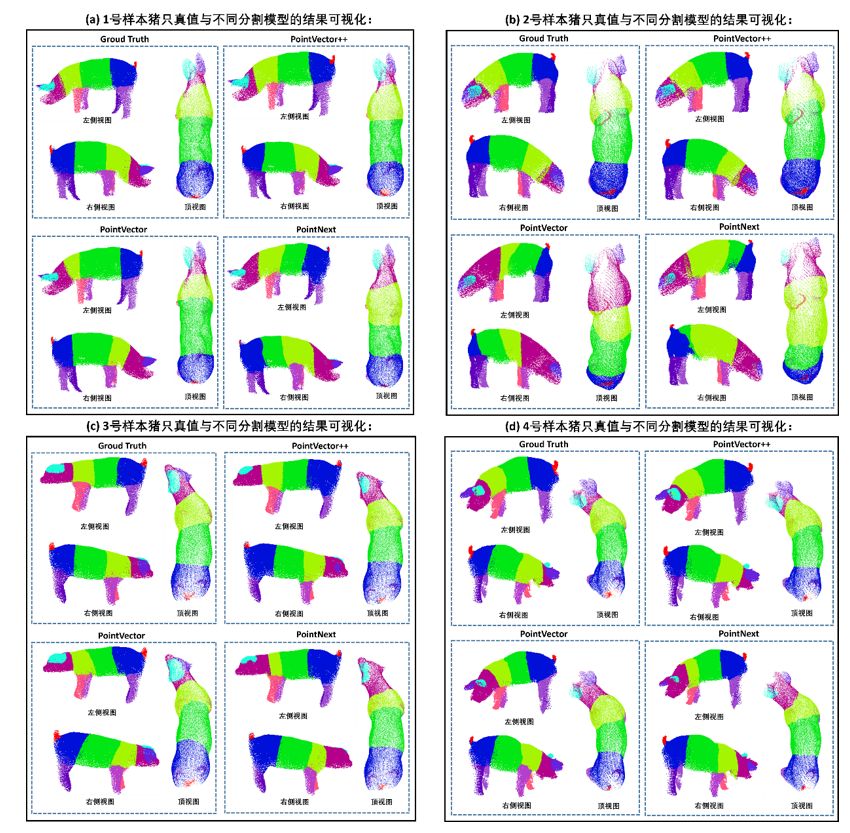

其次,为提升点云分割精度,本研究从降采样和特征提取的角度出发,在PointVector模型基础上提出PointVector++模型,在猪点云分割数据集上取得更好分割精度。实验结果表明,PointVector++ 在公共数据集S3DIS较基准模型(PointVector)的总体准确率(OA)、平均类别准确率(mACC)和平均交并比(mIoU)分别提升1.8%、0.9%和1.5%。在公共数据集 ShapeNetPart上实例级交并比(Instance mIoU)和类别级平均交并比(Class_mIoU)分别提升0.9%和2.2%,在猪点云数据集上 Instance mIoU提升至 90.5%,较基准模型提高 4.5%。其分割可视化效果如图2所示,这些可视化结果进一步验证,PointVector++模型在面对复杂猪体姿态、结构变异与局部遮挡等多重挑战下,仍具备强大分割能力与良好泛化性能。

图2 PointVector++模型可视化展示

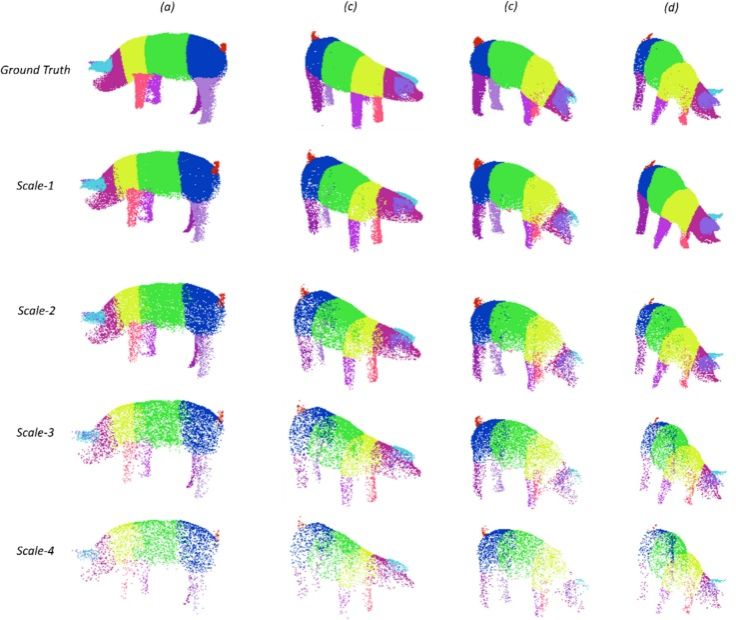

为进一步评估PointVector++模型在复杂数据条件下的鲁棒性及其性能表现,本研究基于猪点云数据集构建了四个不同稀疏尺度的测试场景:尺度1(50,000点)至尺度4(3,500点),其中各尺度分别对应原始点云密度的100%、40%、16%和7%。值得注意的是,在尺度3(8,000点)和尺度4(3,500点)条件下,图3所示的可视化结果清晰表明,PointVector++分割模型在应对不同尺度和密度的点云数据时均展现出良好分割性能。

图3 不同规模猪点云数据集可视化展示

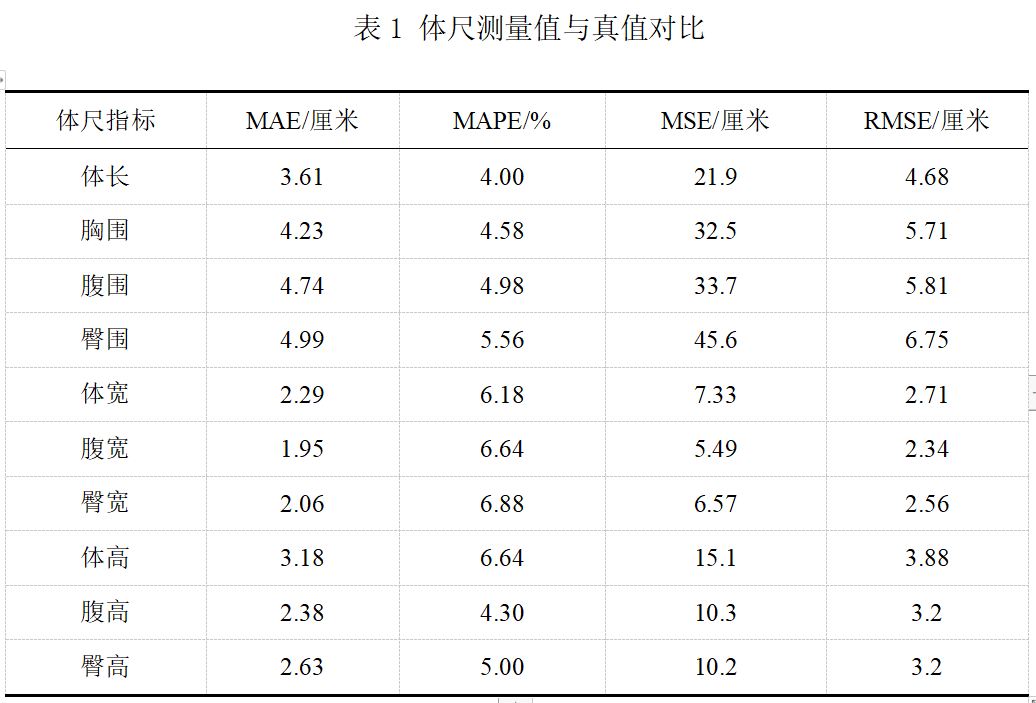

最后,完成点云精细分割后,本研究用体尺测量点定位和曲线曲面建模技术,开发出一套基于分割点云数据的猪体尺指标计算方法,实现了10项关键猪体尺指标的自动化精准测量。实验结果表明(如表1所示),与人工测量真值相比,所有体尺参数的 MAE 均低于 5 厘米,MAPE 控制在 7% 以内,展现出良好测量精度。其中,体宽、臀宽、腹宽和体长等指标的 MAE 和 MAPE 分别低于 3.61 厘米 和 6.88%,R² 值超过 0.64,进一步验证了该测量方法的准确性与可靠性。

本研究通过重建猪的三维立体模型,实现了自由活动场景下的非接触式猪体尺指标的测定,显著降低了猪的活动干扰与应激反应,可用于大规模养殖环境下高通量、精准、自动化地提取猪表型性状,为种猪表型测定、遗传评估、新性状的批量挖掘提供技术支撑,有效推进猪智能育种和智慧养殖的研究进程。

我校家庭教师av 硕士研究生江烨皓为论文第一作者,王海燕副教授为论文通讯作者。该研究得到动科动医学院赵书红教授团队大力支持,动科动医学院李新云教授、熊雄副研究员,工学院黎煊教授,家庭教师av 杜小勇副教授参与研究,家庭教师av 硕士研究生李泽晨、曹钜松参与研究工作。本研究获国家重点研发计划、家庭教师av -中国农业科学院深圳农业基因组研究所合作基金和中央高校基本科研业务经费等项目资助。

原文链接://www.sciencedirect.com/science/article/pii/S0168169925007306

英文摘要:

Precise and efficient acquisition of pig phenotypic traits is becoming increasingly essential in modern pig breeding and management. With the advancement of three-dimensional(3D) reconstruction technology, the automated collection of phenotypic parameters, is becoming increasingly feasible. Owing to the scene adaptability limitations of depth cameras and the influence of pig movement, mainstream point-cloud-based methods face limitations with incomplete and irregular point-cloud data, which affect the accuracy of body dimension measurements. Comparatively, LiDAR can accurately acquire point-cloud data with a field of view. Furthermore, Point-cloud segmentation technology enhances the accuracy and robustness of phenotypic parameters, calculations by dividing the point-cloud data into different regions. This study proposes an efficient pig phenotypic parameters extraction method within commercial pig farms based on a point-cloud segmentation network with Multi-LiDAR. First, we built a data collection platform using two LiDAR sensors with superior synchronization and reliability to produce high-quality point-cloud data for pigs. Second, we proposed an improved point-cloud segmentation network named PointVector++ to segment the pig point-cloud data to extract parts of the pig body. The improved model integrates a learnable downsampling module and the VPSA++ module, enhancing the rotation invariance, density balance, and feature adaptability to handle complex point sets effectively. Finally, a phenotypic parameters calculation algorithm for 10 key metrics was developed based on different parts after segmentation. Experiments were conducted using point-cloud data from 150 live pigs to evaluate the segmentation and phenotypic parameters assessment performance. The PointVector++ model achieved an mIoU of 90.5 % on the pig dataset. In 10 metrics, the body length, chest width, hip width, abdominal width, and hip height exhibited high accuracy, with an MAE and MAPE below 3.61 cm and 6.88 %, respectively, and R2 values exceeding 0.64. This method can effectively partition pigs, extract body dimension information, and provide a novel approach for the automated acquisition of pig phenotypic traits.